Maker Faire Tokyo 2017で出展しつつ、ライブもしてきました。

まずは、ライブのダイジェストからどうぞ。

よく考えたら、ステージに1人でライブ初めてでした・・・。にしては、落ち着いてたと思います。

映像からは何してるのか分からないと思うので、ちゃんとシステムの解説しなきゃと思いました。

まずは使用機材から

- ノートPC(MSIのゲーミングPC、Win10 Insider Preview)

- オーディオI/F(RME Babyface Pro、ビックカメラでポイントで購入)

- DJミキサー(SigmaMIX、もうすぐ頒布開始)

- ターンテーブル(Vestax HandyTrax、amazonで大人の財力で購入)

- スマホ(Motorola Moto Z、Moto Mods気になって購入もModsせず)

- メガネ(JINS MEME、今回は私物使用。他JINSからの借りパク2本あり)

- Tシャツ(No Carp. No Life、タワレコと広島カープのコラボT)

- パンツ(CILANDSIA、高円寺のMACARONICで購入)

- スニーカー(onitsuka & ANREALAGEコラボ、父の日の妻からのプレゼント)

- 靴下とパンツ(ユニクロのやつ)

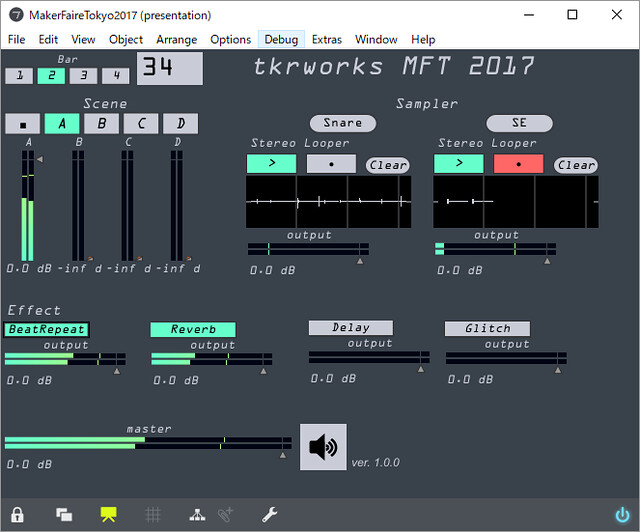

PC上ではお馴染みCycling74 Max7で作った今回のライブ用のイカしたパッチが走ってます。

Maxパッチとライブ用のトラックは弊社スタッフ、岡安啓幸くんに全て制作してもらいました。ちなみに彼、ギタリストの笹久保伸さんと共作でProgressive Formからアルバムも出してるので是非聴いてみて下さい。

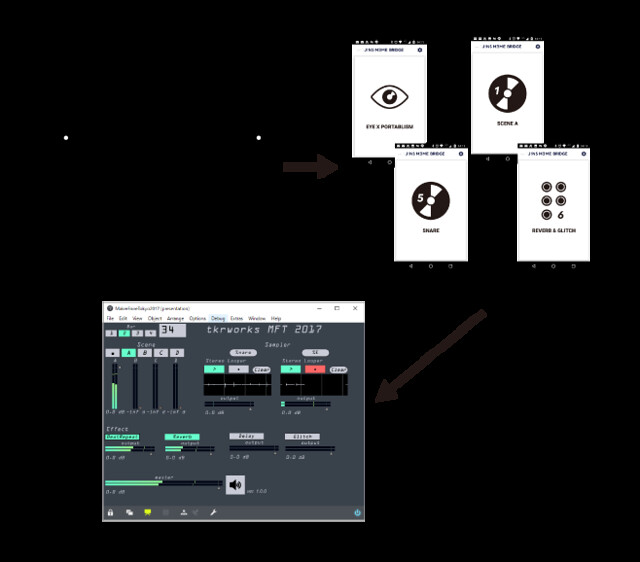

これをMIDIコンで操作しつつ・・・なんてベタな方法ではなく、このパッチを全てJINS MEMEから「目」で操作してたんです。細かい話をすると、JINS MEMEはAndroidとBLEで接続、通信していて、Android上でJINS MEME BRIDGEという一刻も早くJINSさんにリリースして欲しいアプリを走らせ、AndroidからPCにUSBでMIDIを送っていました。

図にするとこんな感じ。

操作方法としては、JINS MEMEをかけて「目」だけを左右に動かし、「SNARE」とか「Delay」って書かれたカードに移動し、まばたきでそのカードを選択。そうするとAndroidからMaxにMIDIがドーンするという仕組み。んで、やっていたことを書くと・・・

- トラックのシーン切り替え

- ワンショット(スネア、SE)の再生

- ルーパーのオンオフ(ワンショットのループREC、オーバーダブ用)

- エフェクト(Stutter、Reverb、Delay、Glitchの4種とReverb&Delay、Reverb&Glitchのコンボ2種)

大きく分けてこの4つの操作を「目」だけでやり、合間にSigmaMIXでローパスフィルターかけたり、HandyTraxでスクラッチしてました。

諺に「目は口ほどに物を言う」とありますが、まさにそうで、ライブ直前ちょい緊張してくると分かりやすく意図しない視線移動のイベントが出まくり「目が泳いでる」的な状態になり焦りましたが、焦って汗でもかいたもんなら、さらにまともに操作できなくなるので、「まー最悪マウスでもプレイできるや」と自分に言い聞かせて気持ちを落ち着かせたら、何とかなりました。

ノー編集のライブ音源をサンクラに上げておきますので、通しでどんなだったか興味ある方は聴いてみて下さい。

ずっと自分で、デバイス作って、パッチ作って、あー音どうしよう・・・というところで一番大事なアウトプットである音楽がおざなりになっていましたが、岡安くんのおかげでハードとソフトで一番良い形で分業でき、見返しても恥ずかしくないライブになりました。分業ってホント大事。彼のおかげで、ようやく自分たちの手で作りたいものをつくり、それを伝えるところまで高いクォリティで持っていくことが出来るようになったと思います。

とはいえ、大きな課題が残ってます。

- ぱっと見、何やってるか分からない(ラップトップミュージシャンを越える勢い)

- 頭ほとんど動かせず(MEMEの6軸センサー位置と向きが・・・)

- 視線識別の精度(改善されたけど、まだまだ・・・)

これらは引き続き考え、改善していかなければいけません。

ちなみに、3つ目の「視線識別の精度」に関しては、大阪電気通信大学工学部基礎理工学科の柳田達雄教授と山本製作所の山本俊一で、JINS MEMEのアカデミックパックから取得できる眼電位センサーのデータ解析及び視線移動の識別手法に関する共同研究を行っています。ぜひ、興味のある方はご支援下さい。

コメントをどうぞ